Рынок бизнес-аналитики растет быстрее рынка ИТ в целом за счет все большей популярности современных BI-платформ, которые сформировались в последние несколько лет в ответ на новые потребности заказчиков в доступности, гибкости и глубоком анализе данных. BI-системы превращаются из сложного инструмента, управление, в средство подготовки отчетности, настаиваемое пользователем в соответствии с его индивидуальными предпочтениями. Тем не менее, по мнению Gartner, темпы роста рынка BI будут постепенно снижаться – с 63,6% в 2015 г. до 19% к 2020 г. благодаря усилению на нем конкуренции и соответственному снижению цен на предлагаемые решения. Перспективы отрасли обсудили участники секции «Business Intelligence», организованной CNews Conferences в рамках CNews FORUM 2017.

Открыл секцию, посвященную бизнес-аналитике Михаил Комаров, директор по развитию бизнеса DIS Group, предложив слушателям задуматься над вопросом, зачем нам нужно все больше и больше данных. Дело в том, что среда вокруг стала намного более сложной и динамичной и для ее оценки нужно намного больше параметров чем раньше. И чтобы успевать реагировать на ее изменения, бизнесу пришлось наращивать мощность и емкость своих аналитических систем. Однако, при этом также росла их стоимость, что для значительной части компаний стало камнем преткновения на пути дальнейшего развития.

Появление технологий Big Data, прежде всего Hadoop, со свободной лицензией и способного работать на массиве обычных серверов вместо заоблачно дорогих специализированных программно-аппаратных комплексов, вызвало прилив энтузиазма среди заказчиков. Но с Hadoop все оказалось не так просто: его бесплатность и нетребовательность к оборудованию нивелировалась большей сложностью процессов обработки данных и необходимостью содержать целый штат программистов и data scientist’ов с отнюдь не мизерными зарплатами.

К тому же, с ростом количества источников, сложности и объема данных, экстремально важной становится задача управления данными (data governance), потому что, не имея достоверных сведений о происхождении, преобразованиях и взаимосвязях данных, нельзя строить аналитические выводы. Так что просто залить все данные в озеро и потом черпать оттуда поразительные инсайты при помощи магических инструментов Big Data не получится.

Значит ли это, что организациям не стоит инвестировать в решения в рамках вычислительной парадигмы MapReduce и сосредоточиться на классических хранилищах данных? Вовсе нет. Нужно научиться управлять своими данными, чтобы получать их в нужное время и в нужном качестве, чем, собственно и занимается компания Informatica, признанный лидер среди сервисов платформ по интеграции данных предприятия (Enterprise Integration Platform as a Service) по мнению Gartner.

В связи с принятием программы «Цифровая экономика», значимость многоаспектной аналитики в масштабе страны сильно возрастает. На этом акцентировал внимание в своем выступлении Эдуард Федечкин, ведущий эксперт по системам бизнес-анализа, Tern. В получении различных аналитических срезов заинтересованы все органы государственного управления на федеральном, региональном и муниципальном уровнях.

Среди задач, решаемых при помощи средств Business Intelligence, эксперт упомянул обеспечение работы ситуационных центров, задачи безопасности страны, прогнозную аналитику в интересах различных ведомств и другие. Некоторые решения имеют более узкоспециализированный характер, такие как анализ тональности публикаций в СМИ или комплексный анализ благонадежности клиента, но они также широко востребованы госзаказчиками и бизнесом.

Отдельного внимания заслуживает применение BI для контроля за работой физических систем. На примере проекта по моделированию потерь в энергосистеме можно судить, насколько это актуально. На основе анализа показаний датчиков и измерительных приборов, BI-система помогает выбрать оптимальные режимы работы и выявить риски отказа оборудования, чтобы провести предупредительный ремонт. Не обходится порой и без курьезов: было дело, что спящий подле трубопровода медведь своим теплом вносил искажения в показания датчиков, а система сигнализировала о неисправности.

Создание аналитического решения обычно это итерационный процесс. Вся система не проектируется целиком, а строится постепенно, блок за блоком, ориентируясь на полученный результат и требования потребителей аналитических данных. Сейчас бы такую методологию назвали «аджайл», но компания Tern работает на рынке более 25 лет и изобрела свой «сотовый подход» к построению сложных аналитических систем, когда этого слова и в помине не было.

Петр Воронин, директор департамента информационных технологий Группы компаний «МЕГАПОЛИС» предложил считать первым шагом в цифровой трансформации бизнеса выполнение в организации проекта по созданию озера данных (Data Lake).

Основная задача Data Lake – сбор структурированных и неструктурированных данных для последующей обработки. В качестве источников данных выступают реляционные БД, кассы и платежные терминалы, приложения SAP, социальные сети и даже IoT датчики. Целевая архитектура озера данных решена в гибридной модели – используется SAP DW и Hadoop.

Это позволило перейти к реализации следующих этапов дорожной карты – электронной коммерции, управления мастер-данными, внедрения аналитических систем на принципах самообслуживания и бизнес-планирования. Для компании, занимающей 5 место среди крупнейших частных компании России по версии Forbes и чей бизнес связан с дистрибуцией и логистикой ставка на BI вполне оправдана – в таких масштабах даже небольшая оптимизация бизнес-процесса приносит ощутимую выгоду, а полный переход на «цифру» - тем более.

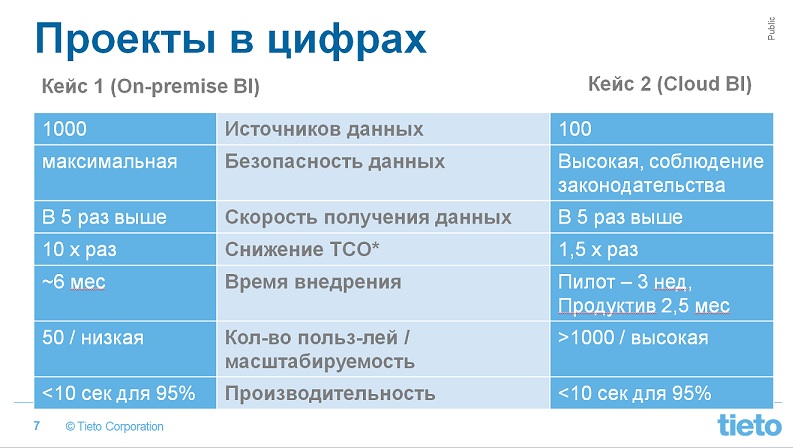

Представители финской компании Tieto, Илья Соловьев, руководитель проектов, и Дмитрий Рыжов, руководитель направления облачных сервисов, на примере двух недавних своих проектов продемонстрировали различные подходы к развертыванию BI-решений – на инфраструктуре заказчика или в облаке и пояснили, по каким критериям стоит делать выбор в пользу одного или другого варианта.

Задача обоими заказчиками была поставлена одинаковая. Нужно было создать единое хранилище данных для консолидации аналитики и отчетности в одной системе. Первый кейс отличался огромным количеством форматов цифровых данных, предстояло обрабатывать более тысячи Excel, txt и csv -файлов различной структуры, причем структуры изменчивой во времени. Количество пользователей было небольшим, всего 50 человек, а требования по безопасности весьма высокие – система должна соответствовать законодательству РФ в области теплоэнергетики. Все это обусловило выбор схемы on-premise, когда все компоненты системы устанавливаются на серверах заказчика. Архитектура решения базировалась на MS SQL и Qlik на стороне пользователя.

Во втором кейсе были следующие особенности: разрозненные BI-решения для различных внутренних систем, относительно небольшое число источников, порядка 100, но зато содержащих значительные объемы данных. Количество пользователей превышало 1000 человек, причем они были широко географически распределены. Практически очевидно, что в такой ситуации эффективным решением будет облако. В качестве платформы выбрали Amazon Web Services с хранилищем S3, на стороне клиента – Tableau. Богатый набор сервисов Amazon позволил экспериментировать с архитектурами и быстро реализовывать идеи по анализу данных, возникающие у бизнес-пользователей.