Большие данные превращаются из сложных, дорогих решений, доступных лишь крупным компаниям, в простые продукты, позволяющие оперативно получать самую разную информацию. О том, как это происходит, говорили участники организованной CNews Conferences онлайн-конференции «Большие данные: цифровизация меняет подходы к аналитике».

Время вызовов

«Наступило время вызовов для индустрии бизнес-аналитики. Возникли новые технологии, с помощью которых можно решать задачи, с которыми не лучшим образом справлялись классические BI-системы», — начал свое выступление Илья Петров, менеджер продукта «Диасофт». Речь идет о технологиях, предлагаемых Google, Amazon, LinkedIn, Netflix, Apach и пр. Теперь вычисления можно производить в режиме реального времени, а значит моментально принимать бизнес-решения.

На сегодняшний день часть потребностей бизнеса не закрывается существующими BI-системами или, наоборот, их возможности являются избыточными. Илья Петров выделил новый класс задач Live Analytics, под которыми понимается возможность быстрого анализа данных и визуализации результатов в режиме реального времени в любых каналах. «Конечно, живая аналитика не решает целый ряд задач, которые решают классические BI-системы. Но она дает простые инструменты, ориентированные на бизнес, а не на ИТ», – говорит эксперт.

Живая аналитика vs классический BI

Источник: Diasoft, 2020

Он перечислил преимущества Live Analitycs. Она значительно дешевле классического BI, внедряется в течение нескольких недель, не требует увеличения штата экспертов и длительного хранения данных и, самое главное, работает с самыми актуальными данными. По словам Ильи Петрова, большинство бизнес-заказчиков хочет видеть на своих мобильных устройствах простые показатели: измерения KPI в штуках и суммах, выполнение план/факта в % и т.д.

Николай Сырцев, главный аналитик «Диасофт», подробно рассказал о разработанной Diasoft системе потоковой обработки и визуализации информации. Она построена по принципу одностраничного приложения, в котором пользователь может создавать дашборды и графики и управлять данными. Информацию можно посмотреть в режиме реального времени вплоть до конкретных точек ее возникновения.

Алексей Струченко, руководитель направления баз данных «Инфосистемы Джет» представил новый продукт Sqream DB, который позволяет обрабатывать данные не на процессоре, а на видеокарте. На видеокарту можно вынести самые ресурсоемкие запросы и таким образом освободить место или самые критичные запросы и таким образом ускорить их обработку. Особенно интересно применение SQream DB на архитектуре IBM Power. «Нам удалось принять участие в тестировании Sqream DB против Oracle DB 12.2. Sqream DB работает в десятки раз быстрее», – говорит эксперт.

Александр Рабкин, региональный директор Sqream в России, подробнее рассказал о решении. Он напомнил, что до настоящего времени большинство имеющихся у компаний данных не анализируется, стоимость аналитических систем растет. Sqream DB позволяет анализировать в 20 раз больше данных, запросы обрабатываются в 100 раз быстрее, а стоимость решения в 10 раз ниже аналогов.

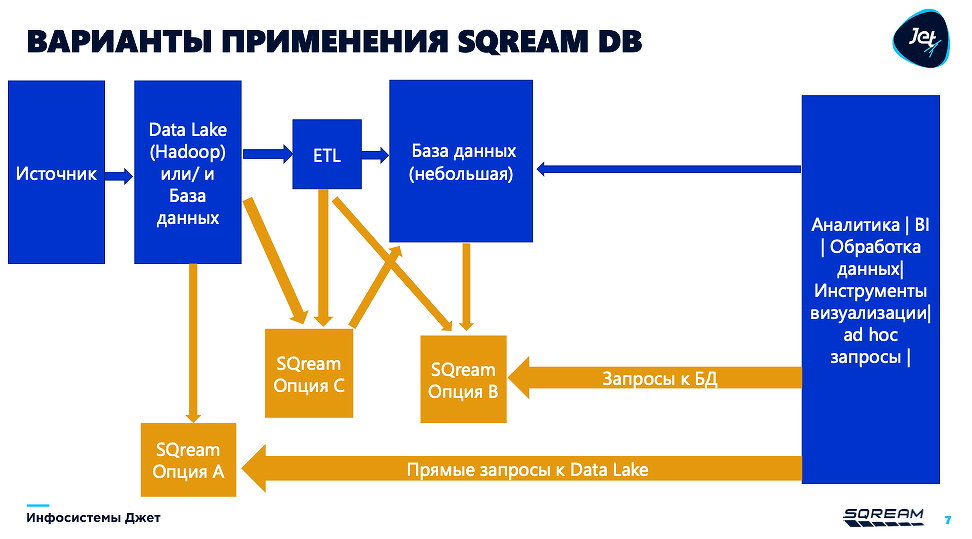

Варианты применения Sqream DB

Источник: Sqream, 2020

Sqream DB обрабатывает данные на графическом процессоре. Оно встраивается в существующую архитектуру и берет на себя обработку самых тяжелых запросов, доля которых, как правило, не превышает 10%. Также решение можно использовать для предварительной обработки данных. Оно работает на стандартном железе и предынтегрировано со всеми источниками данных, такими как Kafka, Spark и т.д.

Александр Рабкин рекомендовал использовать Sqream DB в случаях, когда SQL запросы исполняются слишком долго, есть необходимость анализировать больше данных, а процесс их подготовки слишком долгий и болезненный.

Роман Гоц, директор департамента больших данных и безопасности Atos, представил АнтиCOVID-решения, ориентированные на обеспечение работы компаний после завершения карантина. Это бесконтактные СКУД, программно-аппаратные комплексы для определения первого круга контактов заболевшего человека, контроля образования скоплений людей и ношения масок. Также компания предлагает решение не просто для определения температуры человека, но и обогащения этой информации сведениями о его контактах и т.д.

Все эти данные обрабатываются на удаленных устройствах, а потом передаются в озеро данных Codex DataLake Engine. Это готовое предконфигурированное решение, соответствующее всем требованиям производительности, масштабируемости и безопасности. В качестве примера Роман Гоц привел создание Data Factory в Германии. Этот проект был развернут менее чем за 2 месяца.

Аналитика своими руками

Сергей Кравченко, руководитель разработки BI «Росгосстрах», поделился опытом внедрения в компании корпоративной системы BI-отчетности. Целями проекта было покрытие аналитикой всей компании, повышение эффективности работы процессов, получение единой «точки правды», повышение скорости работы с данными и получения результатов. «Мы хотели, чтобы наша система могла не просто строить графики, но и давать советы», — говорит Сергей Кравченко. Поэтому разработка отчетов была передана пользователям.

На сегодняшний день завершена стандартизация всех проектов, обеспечена отказоустойчивость решения, внедрена матрица ролей, автоматизирована выдача доступов и рассылка оповещений, производится мониторинг и анализ системных логов, ведется построение карты потоков данных. В планах создание магазина данных, интеграция с интранетом и внедрение автоматизированного контроля версий.

«Наша компания рассматривает большие данные как важнейший бизнес-актив и заинтересована в создании различных аналитических сервисов как для себя, так и для бизнес-партнеров», — говорит Дмитрий Прусов, директор департамента продаж продуктов больших данных X5 Retail Group. На первом этапе было собрано около 200 кейсов и под них созданы продуктовые команды. Некоторые решения уже переданы в эксплуатацию, а некоторые еще находятся в разработке. В них используются и технологии искусственного интеллекта, и машинное обучение.

Сейчас активно развивается направление партнерских сервисов — таргетинг рекламы и аналитический портал поставщика. Первый позволяет партнерам посмотреть влияние рекламных кампаний на продажи товаров, оценить их эффективность. Аналитический портал поставщика помогает оценить источники спроса и продаж, учесть сезонные факторы. Доступ на него осуществляется на основании лицензионного договора. На портале уже доступно три сервиса, в течение 2020 года появится еще семь.

Большие данные в сфере ЖКХ

Источник: Росводоканал, 2020

Сергей Путин, ИТ-директор «Росводоканала», отметил, что компания активно развивает нетарифную составляющую бизнеса, то есть стремится предоставлять как можно больше дополнительных услуг как в области строительства водоочистных сооружений и т.д., так и в области развития маркетплейсов по продаже услуг гражданам. Основой второго направления должны стать данные. «У нас около 6,5 миллионов клиентов, о которых мы знаем очень мало, а значит не понимаем, как и что им продавать», — говорит Сергей Путин.

Пока наиболее успешно развиваются проекты по установке измерительного оборудования на всю цепочку подачи воды, которые позволяют снизить уровень потерь и оптимизировать загрузку персонала, отвечающего за устранение протечек. Началась проработка проектов по внедрению систем прогнозирования объемов подачи воды для того, чтобы проактивно корректировать работу оборудования.

О том, как меняется отношение к аналитике больших данных, рассказал Илья Петров, руководитель продукта «Операционный фронт и CRM» департамента «Цифровые решения» компании «Диасофт».

CNews: Какие новые задачи в области аналитики данных становятся актуальными для компаний?

Илья Петров: За последние несколько лет на рынке аналитики данных произошли серьезные изменения: появились устойчивые тренды, технологии и качественно решаемые задачи из области так называемой real-time аналитики – анализа данных в реальном времени. Первопроходцами технологий стали лидеры мировой ИТ-индустрии: Google, Amazon, Linkedin, Netflix, ASF и другие. Эти технологии уже зарекомендовали себя как производительные и надежные в масштабах действительно больших данных – социальных сетей. Они перевернули представление о скорости обработки и допустимом объеме данных – сегодня на основе real-time подхода можно решать задачи мониторинга бизнес-процессов и телеметрии, выполняя непрерывные вычисления над нескончаемым потоком информации.

Мы в «Диасофт» разрабатываем софт для финансового рынка, где скорость принятия решений является определяющим фактором успеха. В итоге, принцип непрерывных вычислений и анализа данных лег в основу нашего продукта Business Sensor для real-time мониторинга бизнес-процессов любой организации.

В компаниях накоплены огромные объемы данных. Настало время превратить их в бизнес-актив, уверен Роман Гоц, директор департамента больших данных и безопасности Atos.

CNews: Как COVID-19 изменил отношение к цифровизации в компаниях?

Роман Гоц: Кризисное время открывает возможности. Успеха достигают лишь те, кто вовремя оптимизирует и автоматизирует бизнес.

О новом способе обработки больших данных рассказал Алексей Струченко, руководитель направления баз данных «Инфосистемы Джет».

CNews: Какие проблемы возникают в ходе анализа больших данных?

Алексей Струченко: Одно из определений больших данных говорит, что это данные, которые невозможно хранить и обрабатывать традиционными способами. В нем кратко описаны две главные проблемы работы с большими данными: хранение и обработка. Если сложности хранения больших данных проще всего решить на уровне железа, то их обработка чаще всего требует новых подходов в разработке программного обеспечения. Одним из таких подходов является использование крайне высокой степени параллелизма, позволяющей обрабатывать большие данные в реальном времени.